فایل robots.txt وردپرس

فایل robots.txt چیست؟

Robots.txt در وردپرس یا هر سایت دیگری یک فایل متنی است که به یک وب سایت اجازه میدهد دستورالعملهایی را برای رباتهای خزنده وب ارائه دهد. موتورهای جستجوگر مانند گوگل از خزندههای وب، که بعضا رباتهای وب نامیده میشوند، برای بایگانی و طبقهبندی وبسایتها استفاده میکنند.

فایل robots.txt شامل مجموعه ای از دستورالعمل هایی است که از رباتها میخواهد تا پروندهها یا فهرستهای خاصی را نادیده بگیرند. این ممکن است به منظور حفظ حریم خصوصی باشد یا به این دلیل که صاحب وب سایت معتقد است که محتوای آن پروندهها و دایرکتوریها برای طبقه بندی وب سایت در موتورهای جستجو بیربط است.

اگر یک وب سایت دارای بیش از یک زیر دامنه باشد، هر زیر دامنه باید یک فایل robots.txt برای خود داشته باشد. توجه به این نکته حائز اهمیت است که تنها رباتهای موتورهای جستجوگر از این فایل robots.txt استفاده نمیکنند. حتی برخی از رباتهای مخرب فایل robots.txt را نیز میخوانند تا بفهمند در ابتدا کدام فایلها و فهرستها را هدف قرار دهند.

Robots.txt یک فایل متنی است که صاحبان وب سایت میتوانند برای رباتهای موتورهای جستجو نحوه خزیدن و ایندکس کردن صفحات در سایت خود را مشخص کنند.

قالب اصلی برای پرونده robots.txt به شرح زیر است:

[User-agent: [user-agent name [Disallow: [URL string not to be crawled [User-agent: [user-agent name [Allow: [URL string to be crawled [Sitemap: [URL of your XML Sitemap

شما می توانید چندین خط دستورالعمل داشته باشید تا URL های خاص را مجاز یا غیرمجاز کنید و چندین نقشه اضافه کنید.

یک نمونه از فایل robots.txt می تواند به این شکل باشد :

* :User-Agent /Allow: /wp-content/uploads /Disallow: /wp-content/plugins /Disallow: /wp-admin Sitemap: https://example.com/sitemap_index.xml

در مثال فوق، ما رباتهای موتورهای جستجو را از خزیدن و ایندکس کردن افزونه ها و پوشه های مدیریت وردپرس محروم کردهایم. در آخر نیز، ما URL نقشه سایت خود را ارائه داده ایم.

آیا برای سایت وردپرس خود به فایل Robots.txt احتیاج دارید؟

اگر فایل robots.txt ندارید، موتورهای جستجو باز هم وب سایت شما را ایندکس میکنند. اما، شما قادر نخواهید بود به موتورهای جستجوگر بگویید که کدام صفحات یا پوشهها نباید بررسی شوند.

فرقی نمیکند که اگر وبسایت شما تازه راهاندازی شده و محتوای زیادی را ندارد، وب سایت شما پیشرفت خواهد کرد و محتوای زیادی در اختیار شما قرار میگیرد، بنابراین به احتمال زیاد می خواهید کنترل خزیدن و فهرست بندی وب سایت خود را بهتر داشته باشید.

شما می توانید از خزیدن رباتها در صفحات غیر ضروری مانند صفحات مدیریت وردپرس، فایلهای مربوط به افزونهها و پوشه مضامین خود جلوگیری کنید.

با غیرفعال کردن خزیدن در صفحات غیر ضروری، به نوعی سهمیه خزیدن خود را ذخیره میکنید. این به موتورهای جستجوگر کمک میکند تا صفحات بیشتری را در سایت شما خزیده و آنها را در اسرع وقت ایندکس کنند.

یکی دیگر از دلایل خوب استفاده از فایل robots.txt زمانی است که میخواهید موتورهای جستجو را از ایندکس کردن یک پست یا صفحه در وب سایت خود متوقف کنید.

این امنترین راه برای پنهان کردن محتوا از عموم مردم نیست، اما به شما کمک میکند تا مانع از نمایش آنها در نتایج جستجو شوید.

یک فایل ایده آل Robots.txt برای وردپرس چگونه است؟

بسیاری از وبسایتهای معروف از یک فایل بسیار ساده robots.txt استفاده میکنند. بسته به نیاز سایت، محتوای آنها ممکن است متفاوت باشد:

*:User-agent :Disallow Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

این فایل robots.txt به همه رباتها اجازه میدهد تا کلیه مطالب را ایندکس کنند و پیوندی به نقشههای وب سایت در اختیار شما قرار میدهد.

برای سایتهای وردپرس قوانین زیر را درفایل robots.txt توصیه می کنیم:

* :User-Agent /Allow: /wp-content/uploads /Disallow: /wp-content/plugins /Disallow: /wp-admin Disallow: /readme.html /Disallow: /refer Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

این به رباتهای موتورهای جستجو میگوید تا تصاویر و فایلهای وردپرس را ایندکس کنند. همچنین این رباتها را از ایندکس فایلهای افزونههای وردپرس، ناحیه مدیریتی وردپرس، پرونده readme و پیوندهای وابسته، منع میکند.

با افزودن نقشههای سایت به فایل robots.txt، شما میتوانید ایندکس همه صفحات موجود در نقشه سایت خود را برای رباتهای گوگل آسان کنید.

اکنون که میدانید یک فایل ایده آل robots.txt چگونه است، اجازه دهید بررسی کنیم که چگونه میتوانید یک فایل robots.txt را در وردپرس ایجاد کنید.

چگونه یک فایل Robots.txt را در وردپرس ایجاد کنیم؟

دو روش برای ایجاد یک فایل robots.txt در وردپرس وجود دارد. می توانید روشی را انتخاب کنید که برای شما مناسب باشد.

روش ۱ : ویرایش فایل Robots.txt با استفاده از Yoast SEO

اگر از افزونه Yoast SEO استفاده میکنید، بهطور پیشفرض آن یک فایل robots.txt را به همراه دارد.

شما می توانید به طور مستقیم از آن برای ایجاد و ویرایش فایل robots.txt از ناحیه مدیریتی وردپرس خود استفاده کنید.

به سادگی از قسمت SEO گزینه Tools را انتخاب کنید و روی پیوند File Editor کلیک کنید.

در صفحه بعد، SEO Yoast فایل robots.txt موجود را به شما نشان میدهد.

اگرفایل robots.txt ندارید، Yoast SEO یک فایل robots.txt برای شما تولید میکند.

به طور پیش فرض، در فایل robots.txt قوانین زیر را اضافه می کند:

*:User-agent / :Disallow

بسیار مهم است که این متن را حتما حذف کنید زیرا همه موتورهای جستجو را از خزیدن وب سایت شما باز می دارد.

پس از حذف متن پیش فرض، میتوانید قوانین robots.txt خود را اضافه کنید. توصیه می کنیم از قالب ایده آل robots.txt که در بالا به اشتراک گذاشتیم استفاده کنید.

پس از اتمام کار ، فراموش نکنید که روی دکمه ” Save robots.txt file” کلیک کنید تا تغییرات خود را ذخیره کنید.

روش ۲ : با استفاده از FTP، فایل Robots.txt را به صورت دستی ویرایش کنید

به سادگی با استفاده از یک سرویس دهنده FTP به حساب میزبانی وردپرس خود متصل شوید.

پس از آن، می توانید فایل robots.txt را در پوشه root وب سایت خود مشاهده کنید.

اگر فایلی را مشاهده نکردید، احتمالاً فایل robots.txt را ندارید. در این صورت، میتوانید خودتان یکی را ایجاد کنید.

Robots.txt یک فایل متنی ساده است، به این معنی که میتوانید آن را در رایانه خود بارگیری کرده و با استفاده از ویرایشگر متن ساده مانند Notepad ویرایش کنید.

پس از ذخیره تغییرات، میتوانید دوباره آن را در پوشه root وب سایت خود بارگذاری کنید.

چگونه فایل Robots.txt خود را تست کنیم؟

پس از ایجاد فایل robots.txt خود، همیشه بهتر است که آن را با استفاده از ابزار تست کننده robots.txt تست کنید.

ابزار تست کننده بسیاری از robots.txt وجود دارد، اما توصیه میکنیم از گوگل وبمستر تولز استفاده کنید.

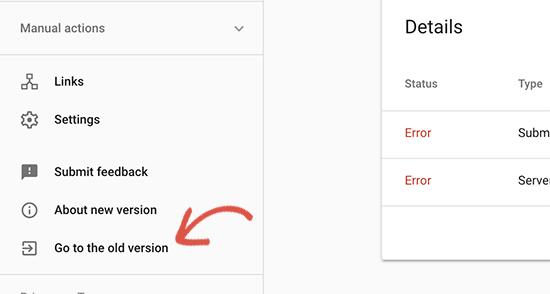

به حساب گوگل وبمستر تولز خود وارد شوید و سپس به وب سایت قدیمی گوگل وبمستر تولز بروید.

از اینجا باید ابزار تستر robots.txt را که درمنوی ” Crawl ” قرار دارد، راه اندازی کنید.

این ابزار به طور خودکار فایل robots.txt وب سایت شما را بارگیری میکند و در صورت وجود خطا به شما هشدار میدهد.

سخن پایانی

هدف از بهینه سازی فایل robots.txt شما جلوگیری از خزیدن موتورهای جستجو در صفحاتی است که نمیخواهید در دسترس عموم باشند. به عنوان مثال، صفحات موجود در پوشه wp-plugins یا صفحات موجود در پوشه مدیریت وردپرس شما.

- توصیه می شود : آموزش سئو سایت وردپرس

امیدواریم این مقاله به شما کمک کند یاد بگیرید که چگونه فایل robots.txt وردپرس خود را برای سئو بهینه کنید.

دیدگاه ها